PVE+iKuai+OpenWrt+fnOS折腾记录

| PVE官方文档 | PBS官方文档 | PMG官方文档 |

|---|

1 背景

早期因联通赠送的光猫性能不支持双LAN口长时间同时上网(存在间歇性断流现象),故从海鲜市场(小黄鱼)上淘了一个N3530小工控机(准系统,无内存条),计划用来安装PVE虚拟机系统,以便搭建软路来处理宽带拨号和作为DHCP服务器分配管理局域网IP,而光猫仅保留作为一个光电信号转换器。

后期陆续购置新硬件摸索各类方案,目前本文已总结了笔者探索使用PVE的各种经验所得。

2 机器配置概览及BIOS优化设置

2.1 N3530工控机配置概览

| 配件类别 | 配件型号 | 数量 | 品牌 | 备注 |

|---|---|---|---|---|

| CPU | Intel(R) Pentium(R) CPU N3530 | 1 | 英特尔Intel | |

| 内存 | Hynix DDR3L-8GB | 1 | 海力士Hynix | 从老笔记本电脑上拆出来的一根DDR3L条子 |

| 硬盘 | Hynix SH920 mSATA 256GB | 1 | 海力士Hynix | |

| 千兆网卡 | Intel I211 Realtek Mini-PCIe RTL8111E/F | 2 1 | 英特尔Intel 瑞昱Realtek | Realtek螃蟹卡是后期购买加装至Mini-PCIe无线网卡口位置 通过拆掉主控板的一个COM接口,用锉刀将外壳挫出一个RJ45网口的尺寸孔实现加装 |

| 主板 | 工控机主板 | 1 | 未知品牌 | |

| 外围接口 | RJ45网线接口 USB-A 3.0 USB-A 2.0 HDMI VGA 麦克风3.5mm 耳机3.5mm COM口 SIM卡槽 | 3 2 4 1 1 1 1 1 1 | 无 | |

| 内围接口 | mSATA Mini-PCIe SATA SATA PWR供电口 | 2 1 1 1 | 无 |

2.2 N3530工控机BIOS优化设置

快速启动菜单按键:F11键

进入BIOS模式按键:ESC或者DEL键

该N3530工控机BIOS是采用经典的AMI(American Megatrends)方案。

- 设置来电自启:

Chipset->South Bridge->Restore AC Power Loss->Power on - 启用CPU内置温度传感器:

Advanced->CPU Configuration->CPU Thermal Configuration->DTS->Enabled - 启用VT-x:

Advanced->CPU Configuration->Intel Virtualization Technology->Enabled - 设置自定义功率模式:

Advanced->CPU Configuration->Power Technology->Custom。(默认是Efficient节能模式)

2.3 i5-12400+云星Matx-Z690 NAS主板配置

2.4 云星Matx-Z690 NAS主板BIOS优化设置

快速启动菜单按键:F11键

3 安装PVE

3.1 PVE安装步骤

- 下载PVE系统镜像:点击跳转(我的情况就是需要下载pve 7.4的iso镜像文件,因为安装pve 8.x会引起

bootloader setup errors报错而导致安装PVE系统失败) - 制作U盘启动项:ventoy。拷贝镜像iso文件到U盘,启动选择pve镜像进入,选择图形安装界面。

- 同意协议。

- 点击option按钮,选择硬盘和ext4格式:

- swapsize=8GB(交换分区请根据自己的硬盘容量和使用情况设置)

- maxroot=50GB(该分区对应PVE系统的local存储空间,主要用于存放ISO镜像和LXC模板(CT Templates),请根据自己的硬盘和使用情况设置)

- minfree=0GB(该分区是定义划分LVM卷组“pve”后剩余的可用空间量。当可用存储空间超过128GB时,其默认值为16GB。)

- 一般是留出这闲置空间用于手动lvcreate逻辑分卷snapshot快照这种操作。但PVE是使用lvmthin,无需闲置空间作为lvmthin的快照存储,因此设置为0即可。

- 如果自己的需求有自行创建逻辑卷快照的需求,请留空使用默认值16GB即可。

- LVM需要VG中的可用空间来创建快照,而lvmthin快照则不需要。

- maxvz=留空(该分区是定义数据卷(data)的最大大小。计算公式:datasize = hdsize - rootsize - swapsize - minfree)

- 国家选择china,时区会自动修改为上海,键盘布局不改。

- 设置密码,邮箱随意。

- 管理网口,默认第一个做管理(enp1s0,pve系统里面识别的第一个网口,N3530工控机中靠近hdmi接口的rj45),第二个做wan口(方便后续维护)。域名hostname设置为pve.lan(这项随便填写都行,有能用的域名可填写上去,可解析到机器用域名管理pve虚拟机);ip:192.168.1.2;掩码:255.255.255.0;网关:192.168.1.1(留给iKuai的地址),DNS:223.5.5.5。

- 查看确认已设置的内容(弹窗),确认安装。

- 访问WEB管理地址并登录:https://192.168.1.2:8006。账户:root。密码:[前面步骤设置的密码]。

- 设置网卡并确保pve能联网。

3.2 PVE升级步骤(7.4->8.x)

3.2.1 替换PVE 7.4的Debian系统软件源和PVE软件源

注:推荐中科大源,清华源可能会遇到大型NAT局域网宽带频繁访问而导致被禁用IP,从而导致出现403 Forbidden。

修改/etc/apt/sources.list文件内容

1 | mv /etc/apt/sources.list /etc/apt/sources.list.bak |

1 | #deb http://ftp.debian.org/debian bullseye main contrib |

1 | #deb http://ftp.debian.org/debian bullseye main contrib |

删除pve-enterprise.list,新建pve-no-subscription.list。

1 | mv /etc/apt/sources.list.d/pve-enterprise.list /etc/apt/sources.list.d/pve-enterprise.list.bak |

1 | echo deb https://mirrors.ustc.edu.cn/proxmox/debian/pve bullseye pve-no-subscription > /etc/apt/sources.list.d/pve-no-subscription.list |

1 | echo deb https://mirrors.tuna.tsinghua.edu.cn/proxmox/debian/pve bullseye pve-no-subscription > /etc/apt/sources.list.d/pve-no-subscription.list |

修改/etc/apt/sources.list.d/ceph.list和/usr/share/perl5/PVE/CLI/pveceph.pm文件内容

1 | mv /etc/apt/sources.list.d/ceph.list /etc/apt/sources.list.d/ceph.list.bak |

1 | echo deb https://mirrors.ustc.edu.cn/proxmox/debian/ceph-quincy bullseye no-subscription > /etc/apt/sources.list.d/ceph.list |

1 | echo deb https://mirrors.tuna.tsinghua.edu.cn/proxmox/debian/ceph-quincy bullseye no-subscription > /etc/apt/sources.list.d/ceph.list |

3.2.2 升级到PVE 7.4最新的版本

1 | apt update -y && apt dist-upgrade -y |

3.2.3 检查版本升级的兼容性

1 | pve7to8 |

3.2.4 替换PVE 8.x的Debian系统软件源和PVE软件源(国内镜像)

注:推荐中科大源,清华源可能会遇到大型NAT局域网宽带频繁访问而导致被禁用IP,从而导致出现403 Forbidden。

修改/etc/apt/sources.list文件内容

1 | mv /etc/apt/sources.list /etc/apt/sources.list.bak |

1 | # deb http://ftp.debian.org/debian bookworm main contrib |

1 | # deb http://ftp.debian.org/debian bookworm main contrib |

删除pve-enterprise.list,新建pve-no-subscription.list。

1 | mv /etc/apt/sources.list.d/pve-enterprise.list /etc/apt/sources.list.d/pve-enterprise.list.bak |

1 | echo deb https://mirrors.ustc.edu.cn/proxmox/debian/pve bookworm pve-no-subscription > /etc/apt/sources.list.d/pve-no-subscription.list |

1 | echo deb https://mirrors.tuna.tsinghua.edu.cn/proxmox/debian/pve bookworm pve-no-subscription > /etc/apt/sources.list.d/pve-no-subscription.list |

修改/etc/apt/sources.list.d/ceph.list和/usr/share/perl5/PVE/CLI/pveceph.pm文件内容

1 | mv /etc/apt/sources.list.d/ceph.list /etc/apt/sources.list.d/ceph.list.bak |

1 | echo deb https://mirrors.ustc.edu.cn/proxmox/debian/ceph-quincy bookworm no-subscription > /etc/apt/sources.list.d/ceph.list |

1 | echo deb https://mirrors.tuna.tsinghua.edu.cn/proxmox/debian/ceph-quincy bookworm no-subscription > /etc/apt/sources.list.d/ceph.list |

3.2.5 替换LXC模板(CT Templates)镜像源

修改/usr/share/perl5/PVE/APLInfo.pm文件内容,针对 /usr/share/perl5/PVE/APLInfo.pm 文件的修改,重启后生效。

1 | cp /usr/share/perl5/PVE/APLInfo.pm /usr/share/perl5/PVE/APLInfo.pm.bak |

1 | sed -i "s#http://download.proxmox.com/images#https://mirrors.ustc.edu.cn/proxmox/images#g" /usr/share/perl5/PVE/APLInfo.pm |

1 | sed -i "s#http://download.proxmox.com/images#https://mirrors.tuna.tsinghua.edu.cn/proxmox/images#g" /usr/share/perl5/PVE/APLInfo.pm |

3.2.6 开始正式升级

1 | apt update -y && apt dist-upgrade -y |

升级中会出现一些交互界面,下面是官网的建议(不清楚的选项,可以选择推荐参数)

1 | /etc/issue -> Proxmox VE will auto-generate this file on boot, and it has only cosmetic effects on the login console. |

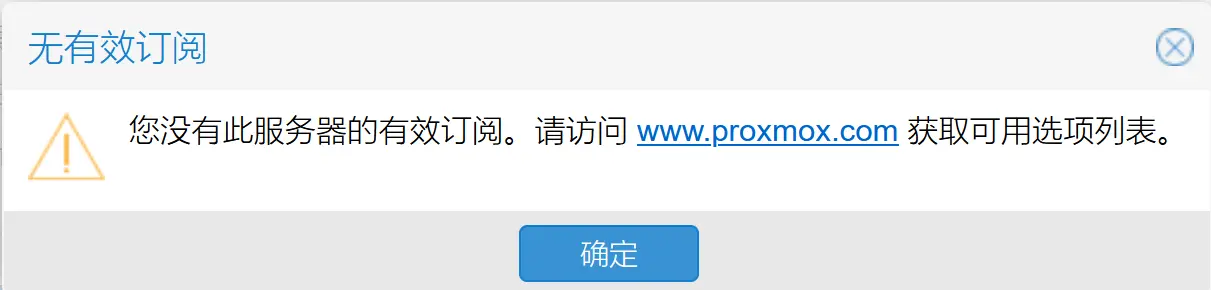

3.2.7 去除未订阅提示

完成如下文件内容修改后,注销浏览器当前的PVE登录信息,并重新登录就没有提示弹窗了。

/usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js

1 | cp /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js.bak |

「无有效订阅」的提示弹窗

「无有效订阅」的提示弹窗3.2.8 网卡mac地址绑定网卡名称

如果PVE宿主机经常要变更硬件的话,这个步骤的操作很重要,详看PVE宿主机更替硬件后导致失联无法访问网页后台

3.2.9 后续PVE系统日常更新:

1 | apt update -y && apt dist-upgrade -y |

4 PVE安装和使用遇到的坑

4.1 PVE安装到99%时出现unable to install the EFI boot loader on '/dev/sda'

报错信息:

1 | bootloader setup errors: |

原因:PVE 8.0版本镜像īso不兼容N3530工控机,估计是bug。参考其他帖子说的只保留usb的uefi设备,依旧也会报错。并且因为机器的bios设置也比较繁琐,我反复尝试将其设置为csm模式,机器始终无法以csm模式启动,估计该主板的bios也是魔改过有bug的。因此导致也无法以csm模式安装pve。

解决方法:安装pve 7.4版本,再升级到pve 8.x。

4.2 USB键盘一直插着时会无法响应的,无法进入并操控BIOS,只有CTRL+ALT+DELETE可以响应

原因:推测为N3530工控机BIOS的驱动BUG。

解决方法:先不插键盘启动机器,看屏幕右下角等待主板自检代码走到99阶段,快速插上键盘,摁DEL键。如果一次不成功,就使用CTRL+ALT+DELETE强制重启,继续尝试该操作。

4.3 hdmi屏幕不显bios

N3530工控机主板BIOS内置驱动对普通HDMI小屏幕兼容性不好,只有成功启动PVE系统后才会正常显示画面,而在自检阶段和BIOS界面只会显示白屏或者花屏,接大屏驱动板兼容性好点。

4.4 后面加装的RTL8211网卡不识别

原因:因为安装pve系统之前未加装好螃蟹卡RTL8111,因此后续加装之后,pve系统并未识别到。

解决方法:重装pve系统。(驱动源码编译方案,也有编译报错,不好解决,推荐是重装pve,让pve自动打驱动)

4.5 工控机重启bug,看门狗导致重启很长时间

原因:未查明,只要一重启,就会长时间卡在看门狗的错误提示。

错误提示:

1 | watchgod: watchdog0: watchdog did't did not stop! |

解决方法:无法解决,只能长时间等待完成重启或者强制关机重开。

P.S. 尝试在主板BIOS中主动启用看门狗计时器设置Advanced->SIO MISC Configuration->Watchdog Dog Timer->Enabled仍无法解决,该问题暂未查明原因。

4.6 Repository 'Debian bookworm' changed its 'non-free component' value from 'non-free' to 'non-free non-free-firmware'

问题现象:运行apt update出现报错:Repository 'Debian bookworm' changed its 'non-free component' value from 'non-free' to 'non-free non-free-firmware'

问题原因:Debian 12版本(bookworm)的非自有固件包(如硬件驱动程序)不再放在non-free目录中,而是non-free-firmware目录。

解决方法1(修正/etc/apt/sources.list软件源):

1 | # 确保软件源中添加了non-free-firmware目录,而不仅仅只有non-free目录 |

解决方法2(直接屏蔽该错误):

创建一个文件/etc/apt/apt.conf.d/no-bookworm-firmware.conf,写入内容如下:

1 | APT::Get::Update::SourceListWarnings::NonFreeFirmware "false"; |

4.7 安装独立显卡的机器中PVE系统里面识别不到核显设备

问题现象:华硕Z690-A Gaming WiFi D4主板在安装独立显卡后,运行ls pci | grep VGA找不到核显的VGA设备。

问题原因:主板BIOS未有开启核显。

解决方法:

- 开启iGPU设置:

Advanced->System Agent (SA) Configuration->Graphics Configuration->iGPU Multi-Monitor->Enabled- Intel 11代及以后的CPU核显不支持传统Legacy显示方式,如果看不到在主板BIOS中找不到iGPU设置选项的话,请设置关闭CSM:

BOOT->CSM (Compatibility Support Module)->Launch CSM->Disabled

- Intel 11代及以后的CPU核显不支持传统Legacy显示方式,如果看不到在主板BIOS中找不到iGPU设置选项的话,请设置关闭CSM:

- 设置首选显示设备为核显:

Advanced->System Agent (SA) Configuration->Graphics Configuration->Primary Display->CPU Graphics- 一般其他主板型号可能有的选项值:

- Auto

- CPU Graphics:核显

- PEG Slot (PCI-e Graphics Device):独立显卡

- PCIE (PCI-e Graphics Device)

- IGD (Internal Graphics Device):一般多指核显,除非主板自带有北桥显示芯片

- PCI (PCI Graphics Device)

- 一般其他主板型号可能有的选项值:

4.8 PVE概要页面利用率图标信息无法显示

问题原因:rrdcached服务异常,某些情况下也可能会导致所有虚拟机显示「状态: unknown」。

解决方法:

1 | systemctl stop rrdcached |

4.9 PVE面板节点和所有虚拟机显示「状态: unknown」,虚拟机正常运行

问题原因:pve的节点状态守护程序pvestatd异常。

解决方法:

1 | #查看状态和重启服务 |

4.10 使用ventoy引导安装PVE后,无法正常启动PVE

问题:使用ventoy引导安装PVE后,安装完成重启,初次开机就卡在loading initial ramdisk或者黑屏

原因:因为ventoy偷偷给PVE添加启动内核参数rdinit=/vtoy/vtoy。据反复实验,在ventoy使用grub模式加载PVE镜像引导的话,这个参数百分百会被偷偷加入,使用正常UEFI模式加载偶尔会出现这种情况。测试使用的ventoy版本为v1.1.05。

解决方法:

- 强制重启主机,在出现PVE引导菜单时,按E键,进入grub编辑模式

- 方向键定位到

linux开头一行,删除rdinit=/vtoy/vtoy参数,Ctrl+X启动配置,进入系统引导加载启动。 - 登录PVE终端后台

- 查看并修改所有涉及内核参数的文件

1 | nano /etc/default/grub |

- 移除参数后,重启机器,PVE启动应该就能恢复正常

4.11 KVM和LXC被锁定lock无法启动

原因:回滚快照或者备份被异常中断都可能导致出现这种情况,对应的虚拟机状态可以看见一个被锁的图标。

解决方法:

- KVM虚拟机解锁命名:

qm unlock vmid,例如qm unlock 100。 - LXC虚拟机解锁命名:

pct unlock vmid,例如pct unlock 101。

4.12 Intel 13/14代CPU搭建的PVE机器频繁宕机

问题现象:Intel 13/14代CPU搭建的PVE机器经常会出现宕机现象,基本每隔两天就会出现失联,ssh也无法正常连接到PVE。此外还有一个很严重的现象,即未设置任何硬件直通的内核启动参数情况下,仍然会导致十分随机的PVE系统启动卡住现象或者出现随机启动报错,包括并不仅限于:

- PVE启动卡在loading initial ramdisk

- Proxmox stuck in /dev/mapper/pve-root: clean:光标在下一行,并且光标不会闪烁,就显示一个下划线

_。 BUG: Bad page state in process init pfn:11386d- 启动虚拟机经常遇到:Failed to create the configured network,从而导致无法启动

- 无法正常卸载分区,reboot系统也会卡住在

unmount filesystem xxxx(xxxx指UUID) - 导致PBS备份失败:ERROR: Backup of VM 102 failed - lvcreate snapshot 'pve/snap_vm-102-disk-0_vzdump' error

问题原因:CPU缩缸(辣鸡Intel(ಥ﹏ಥ))。相信我,修改grub引导参数设置nomodeset什么的都不管用的,仍然是随机崩溃宕机或者开机随机卡住。

解决方法:为CPU设置BIOS锁频和稳压,确保CPU可以稳定运行工作。

4.13 PVE宕机故障的排查手段

- PVE管理后台->PVE节点->系统->系统日志

- 排障思路:

1 | # 查看系统版本 |

4.14 PVE宿主机更替硬件后导致失联无法访问网页后台

问题现象:PVE更替硬件,重新开机后,直连PVE主机显示器显示启动正常,但是无法通过IP地址访问PVE管理后台。

原因:PVE更替硬件,例如加装或者拆卸网卡/硬盘/显卡等设置,会导致PCI设备变动,对应的PCI编号变更。这样会导致网卡名称发生变动,但是PVE自身没法自动识别和更新这些信息,网络接口信息/etc/network/interfaces仍然是记录着旧的网卡名称信息,因此重启开机后就失联无法访问。

解决方法:

- 永久解决方案(推荐):使用.link文件固定网卡名字

- 查看当前所有物理网卡的MAC地址

1

2

3

4ip addr

# 输出信息中lan开头设备就是物理网卡,其中00:03:ee:00:xx:dc就是lan1的MAC地址

# lan1: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc mq master vmbr3 state DOWN group default qlen 1000

# link/ether 00:03:ee:00:xx:dc brd ff:ff:ff:ff:ff:ff - 在

/etc/systemd/network/路径下创建网卡对应的.link文件10-persistent-net.link:1

2

3

4

5[Match]

MACAddress=00:03:ee:00:xx:dc

[Link]

Name=lan1 - 其余网卡就按照

1[x]-persistent-net.link和lan[x]的命名方式创建.link文件和设置网卡名称即可。

- 查看当前所有物理网卡的MAC地址

- 临时解决方案(不推荐):显示器直连PVE宿主机器,登录帐号。但这个方法不推荐,如果机器网卡很多的话,压根无法知道哪个网卡是以前的管理口。

1

2

3

4

5# 查看当前所有网卡名称

ip addr

# 把查看到新的网卡名称,更新到/etc/network/interfaces文件中

nano /etc/network/interfaces

systemctl restart network

5 PVE硬件直通

IOMMU允许系统设备在虚拟内存中进行寻址,也就是将虚拟内存地址映射为物理内存地址,让实体设备可以在虚拟的内存环境中工作,这样可以帮助系统扩充内存容量,提升性能。

换而言之,IOMMU可以使VM虚拟机能够接入一些物理设备,比如PCIe中的网卡、声卡、显卡,VM虚拟机可以直接或间接使用这些设备。

在创建虚拟机时,芯片组一定要q35。因为Q35,才能PCIE直通,否则就是PCI直通。

5.1 检查硬件是否支持直通(BIOS内查看Advanced高级选项)

- 开启CPU虚拟化:Intel: VT-X(Intel Virtual Technology)。AMD: AMD-V(SVM, Secure Virtual Machine)。

- 开启硬件直通功能:Intel: Intel VT-d。AMD: IOMMU。

- 部分主板会有和Intel VT-d/IOMMU相关联的

Memory Remap Feature设置。

5.2 PVE提示No IOMMU detected

当pve未启用IOMMU或者硬件不支持直通(即使手动设置PVE开启IOMMU)时,在ProxmoxVE(PVE)的VM/VPS中添加PCI设备时候提示:No IOMMU detected, please activate it.See Documentation for further information.

解决方法:请确认自己的机器是否支持VT-X和VT-d等CPU虚拟化和直通硬件功能,并是否已开启IOMMU。若硬件不支持,建议更换支持这些功能特性的硬件设备。

5.3 PVE启用IOMMU

- 编辑grub文件:

nano /etc/default/grub - 找到GRUB_CMDLINE_LINUX_DEFAULT这一行:

1 | ... |

- 根据CPU类型修改

1 | ... |

1 | ... |

- 编辑cmdline:

nano /etc/kernel/cmdline。(若不存在,则新建该文件) - 根据CPU类型在第一行末尾添加:

1 | quiet intel_iommu=on |

1 | quiet amd_iommu=on |

5.4 验证PVE的IOMMU是否启用

- 查询命令:

dmesg | grep -e DMAR -e IOMMU。输出显示DMAR: IOMMU enabled或者DMAR: Intel(R) Virtualization Technology for Directed I/O证明已启用。 - 实操验证:虚拟机分配PCI设备时可见。

5.5 PVE启用PT模式

- 编辑grub文件:

nano /etc/default/grub - 找到GRUB_CMDLINE_LINUX_DEFAULT这一行:

1 | ... |

- 附加参数iommu=pt,Intel和AMD芯片均可使用这个参数。

- 添加模块设置(5.4内核需自行添加,现行版本自带有添加):

nano /etc/modules。没有如下内容需添加。

1 | vfio |

- 刷新 initramfs:

update-initramfs -u -k all - 更新 grub:

update-grub

5.6 直通i9-13900K核显UHD770给虚拟机Windows11

5.6.1 Intel 核显直通 optionROM方案

- 访问igd仓库,在仓库代码根路径下,下载

gen12_gop.rom和gen12_igd.rom两个文件。 - 将这两个文件复制到

/usr/share/kvm/目录下。 - 编辑Windows虚拟机配置文件(示例Windows虚拟机ID为103):

1 | nano /etc/pve/qemu-server/103.conf |

- 注意在启动前,将虚拟机->硬件->显示->设置为「无 (none)」,即对应虚拟机配置文件的参数:

vga: none - 通过远程桌面连接RDP接入虚拟机系统,下载并安装最新的Intel的核显驱动(已测试正常的驱动版本

32.0.101.6732,驱动程序日期:2025/4/1)。

6 创建PVE虚拟机/LXC容器

若机器硬件性能不太足够的话,不建议安装win系统,win系统极度消耗硬件性能(即便是空载待机状态也消耗很大),而这影响openwrt的性能。比如我的情况:安装了tiny10系统,千兆网线,宽带500M实测不到300Mbp/s(这里是指用广东联通宽带测速平台测试的结果,实际iKuai主路由测试速率却又正常),局域网速率最高只能到700Mbp/s的速率。关闭后tiny10后,实测宽带速率恢复正常,局域网速率跑到900Mbp/s出头)

6.1 PVE基础设置

- 访问WEB管理地址并登录:https://192.168.1.2:8006,账户:root。密码:[前面安装步骤设置的密码]。

- 根据硬件网卡情况,添加并设置好虚拟网桥Linux Bridge:创建>Linux Bridge>桥接接口填写物理网口地址名称。以我的机器为例,机器三个物理网口,PVE新建5个网桥,前三个网桥和物理网口绑定,第四个网桥用作iKuai和OpenWrt之间的传输,第五个网桥用作其他虚拟机系统的传输。

6.2 安装LXC容器后的基础设置

6.2.1 适用于CT模板(debian-12-standard_12.7-1_amd64)

1 | mv /etc/apt/sources.list /etc/apt/sources.list.bak |

6.3 安装爱快iKuai(KVM虚拟机)

- 下载iKuai镜像:点击跳转

- local-内容-上传:iKuai的安装镜像文件。

- 创建虚拟机,命名虚拟机名称iKuai,VM编号100。

- CD/DVD光盘镜像文件选择刚上传的ISO镜像。

- 主硬盘分配2G,额外添加EFI磁盘(不勾选添加密钥),CPU给4核(host),内存分配4G(64位iKuai要求4G内存),网卡模型选择VirtIO(半虚拟化)。

- 完成新建后,在硬件标签页中继续完成添加所有网桥,网桥的防火墙全部关掉(使用iKuai的),模型都选择半虚拟化。

- 在选项标签页中把「开机自启动」开启,启动顺序设置为1,引导顺序只开disk‘xxxx’磁盘,把网络启动关掉,CD启动上移到第一位。

- 点击启动虚拟机,完成安装即可。

- iKuai内识别的第一个网卡设置为lan1。

- 输入字母o回车进入其「其他选项」,开启外网访问web。

- 访问WEB管理地址并登录:http://192.168.1.1:80。默认账户:admin。默认密码:admin。

6.4 安装OpenWrt(KVM虚拟机)

6.4.1 OpenWrt镜像的选择

- Bleach OpenWrt:推荐(本教程使用该固件)。内置SmartDNS,软件包空间设置为1G,剩余五百多兆。

- eSir GDQ 高大全:eSir的高大全固件。不推荐。没有内置SmartDNS拓展(我测试时安装SmartDNS并未出现有服务项,无效)。并且相较于Blench版本,较为繁琐。软件包空间只剩余几兆,需自己手动扩盘。

6.4.2 安装步骤

- 创建虚拟机,命名虚拟机名称openwrt,VM编号101。

- CD/DVD光盘镜像文件设置为无介质。

- 主硬盘随便分配(后续会删除),额外添加EFI磁盘(不勾选添加密钥),CPU给4核(KVM64),内存分配4G,网卡模型选择VirtIO(半虚拟化)。

- 网桥只选择第四个网桥(用作iKuai和OpenWrt之间的传输),网卡的防火墙全部关掉(使用iKuai的),模型选择半虚拟化。

- 下载OpenWrt镜像:见上一小节

- local-内容-上传:OpenWrt的镜像文件。

- 向虚拟机导入OpenWrt镜像:

qm importdisk 101 /var/lib/vz/template/iso/bleach-plus-20230826-openwrt-x86-64-generic-squashfs-combined-efi.img local-lvm。(直接写盘即可,无需安装)。 - 在pve管理页面中,加载刚才导入镜像生成的磁盘。

- 在选项标签页中把「开机自启动」开启,启动顺序设置为2,引导顺序只开disk‘xxxx’磁盘,把网络启动关掉。

- 点击启动虚拟机。

- pve中用shell:

vi /etc/config/network,将lan口ip改为192.168.1.3,reboot重启。vim编辑:按i进入修改模式,按esc退出编辑模式,输入 :wq回车保存修改。 - 访问WEB管理地址并登录:http://192.168.1.3。默认账户:root。默认密码:password。

6.5 安装OpenWrt(LXC容器)

6.5.1 OpenWrt根文件镜像的选择

- ImmortalWrt:推荐(本教程使用该固件)。选择

ROOTFS (SQUASHFS)类型下载,编写教程时最新版本为immortalwrt-24.10.1-x86-64-generic-squashfs-rootfs.img.gz。 - OpenWrt官方固件

6.5.2 安装步骤

- 在PVE宿主机上安装

squashfs-tools软件包:apt install squashfs-tools。 - 下载OpenWrt根文件镜像:见上一小节

- 解压gz包:

gunzip immortalwrt-24.10.1-x86-64-generic-squashfs-rootfs.img.gz(gunzip解压gz包之后会自动删除gz包的)。 - 解压img镜像文件:

unsquashfs openwrt-x86-64-generic-squashfs-rootfs.img,解压路径为当前路径下的squashfs-root文件夹。 - 打包tar.gz格式,作为LXC模版:

1 | cd squashfs-root |

- 手动创建LXC容器(这里不能用网页端选择LXC模板来创建,会报错),若需要后期编辑LXC虚拟机的配置项,使用命令编辑

nano /etc/pve/lxc/101.conf。

1 | pct create 101 /var/lib/vz/template/cache/immortalwrt-24.10.1-x86-64-generic-rootfs.tar.gz --rootfs local-lvm:2 --ostype unmanaged --hostname openwrt --arch amd64 --cores 4 --memory 2048 --swap 0 -net0 bridge=vmbr4,name=eth0 -net1 bridge=vmbr4,name=eth1 --features nesting=1 --unprivileged 0 |

参数说明:

pct create 100: 创建一个 ID 为 100 的容器。/var/lib/vz/template/cache/openwrt-x86-64-generic-rootfs.tar.gz: 指定要使用的根文件系统模板的路径。这里是 OpenWRT 的根文件系统。--rootfs local-lvm:2: 设置容器的根文件系统存储位置。local-lvm表示使用local-lvm的空间,2表示分配2GB的存储空间。--ostype unmanaged: 指定操作系统类型为"unmanaged",表示 Proxmox 不会对已知操作系统进行特定优化。--hostname openwrt: 将容器的主机名设置为 openwrt。--arch amd64: 指定容器的架构为 64 位(amd64)。--cores 4: 分配 4 个 CPU 核心给容器。--memory 2048: 分配 2048 MB 的内存给容器。--swap 0: 分配 0 MB 的交换空间给容器。--net0 bridge=vmbr0,name=eth0: 配置第一个网络接口,连接到 vmbr0 桥接,并将接口命名为 eth0。--features nesting=1: 启用特定功能。nesting=1 允许嵌套虚拟化。--unprivileged 0:表示使用特权模式(该选项一定要开启,否则OpenWrt的DNSMasq服务无法正常启动)

- 为容器追加额外的参数设置

nano /etc/pve/lxc/101.conf

1 | lxc.cgroup2.devices.allow: a |

参数说明:这些配置项主要用于确保容器能够正常访问网络设备,并设置适当的权限和挂载点,以便 OpenWRT 能够正常工作。

lxc.cgroup2.devices.allow: a:允许容器访问所有设备。a 表示所有设备权限。lxc.cap.drop::该参数用于指定要从容器中删除的 Linux 功能(capabilities)。如果没有指定任何功能,表示不删除任何功能。此项通常用于限制容器的特权。lxc.mount.auto: proc:mixed sys:ro cgroup:mixed:lxc.mount.auto用于自动挂载文件系统。proc:mixed表示以混合模式挂载/proc文件系统,允许容器访问进程信息。sys:ro表示以只读模式挂载/sys文件系统,容器可以读取系统信息但不能修改。cgroup:mixed表示以混合模式挂载cgroup文件系统,用于管理资源限制。

lxc.mount.entry: /dev/net/tun dev/net/tun none bind,create=file:该参数用于手动挂载设备。/dev/net/tun是 TUN/TAP 虚拟网络设备的路径。dev/net/tun是容器内的挂载点。none表示不指定文件系统类型。bind表示将主机的设备绑定到容器中。create=file表示如果挂载点不存在则创建它。

- 在PVE管理网页打开进入LXC的shell,修改固件的LAN口IP,让OpenWrt可以访问外网:

1 | vim /etc/config/network |

- 安装软件包:

- 美化皮肤:

luci-i18n-argon-config-zh-cn - OpenClash:

luci-app-openclash

- 美化皮肤:

6.6 安装飞牛私有云fnOS(KVM虚拟机)

- 下载飞牛私有云fnOS镜像:点击跳转

- local-内容-上传:fnOS的安装镜像文件。

- 创建虚拟机,命名虚拟机名称fnOS,VM编号102。

- CD/DVD光盘镜像文件选择刚上传的ISO镜像。

- 主硬盘分配64G,额外添加EFI磁盘(不勾选添加密钥),CPU给4核(host),内存分配6G(fnOS系统内存需求还是有点大的),网卡模型选择VirtIO(半虚拟化)。

- 其他硬盘后续自行根据需求添加。

- 网桥只选择第五个网桥(用作iKuai和fnOS之间的传输),网卡的防火墙全部关掉(使用iKuai的),模型选择半虚拟化。

- 在选项标签页中把「开机自启动」开启,启动顺序设置为3,引导顺序只开disk‘xxxx’磁盘,把网络启动关掉,CD启动上移到第一位。

- 点击启动虚拟机。

- 选择

Graphical Install进行图形化安装流程。 - 选择系统主硬盘进行安装。

- 系统分区大小:64GB;Swap大小:0GB。(有论坛帖子反馈开启

Swap cache时,某些下载应用例如QBittorrent可能会引导硬盘持续读取和CPU的异常占用。永久禁用Swap还需要修改fstab文件。) - 点击确认安装,选择网卡界面,直接默认选项确认即可。

- 安装完成后,点击确认开始重启。摁

ESC键,进入虚拟机BIOS设置界面,重新选择硬盘分区作为启动项启动。(否则默认启动CD) - 出现

Debian GNU/Linux系统引导选项就是安装成功了 - 进入到传统Linux登录界面(无GUI),这里能看到WEB管理地址。若需要固定IP地址,在

iKuai中找到对应MAC地址加入静态分配表即可。 - 访问WEB管理地址并登录:http://192.168.1.5:5666/。首次访问会提示创建NAS

设备名称``超级管理员账号``密码``确认密码。

6.6.1 飞牛私有云fnOS的硬件直通设置

新版PVE无需额外设置什么直通参数,系统内核自带默认开启了IOMMU支持。

需要额外注意的一点是:安装飞牛系统时先不要加PCI设备,照常安装飞牛fnOS系统,正常设置完成之后,再关闭虚拟机添加PCI设备,例如核显和sata控制器(添加PCI设备->原始设备时,按默认参数即可,也无需勾选「所有功能」)。

- 核显设备:Alder Lake-S GT1 [UHD Graphics 730]

- SATA控制器:Alder Lake-S PCH SATA Controller [AHCI Mode]

6.7 安装Proxmox Backup Server(PBS备份服务器)(LXC容器)

- 创建LXC容器配置(debian-12-standard_12.7-1_amd64)

- 核心:2

- 内存:512MB

- SWAP:512MB

- 磁盘:10GB

- 网桥和网卡:eth0,vmbr4,

10.10.10.8/24,10.10.10.1(请根据自行实际情况设置)

- 替换debian系统镜像源和配置系统时区。

- 添加Proxmox Backup Server的软件源

- 方案一:配置

pbs-enterprise.list1

echo deb http://mirrors.ustc.edu.cn/proxmox/debian/pbs bookworm pbs-no-subscription > /etc/apt/sources.list.d/pbs-enterprise.list

- 方案二:

nano /etc/apt/sources.list1

deb http://mirrors.ustc.edu.cn/proxmox/debian/pbs bookworm pbs-no-subscription

- 方案一:配置

- 添加Proxmox的GPG Key,使用APT安装proxmox-backup-server包(可以尝试直接安装看看,若报错再下载GPG KEY)

1 | wget https://enterprise.proxmox.com/debian/proxmox-release-bookworm.gpg -O /etc/apt/trusted.gpg.d/proxmox-release-bookworm.gpg |

- 提示

pbs-enterprise.list配置文件修改意见,使用默认选项NO,即保持当前配置文件,不作任何修改。

1 | Configuration file '/etc/apt/sources.list.d/pbs-enterprise.list' |

- 访问WEB管理地址并登录:https://10.10.10.8:8007/。(root账户登录,领域为

Linux PAM standard authentication。注意别选错为Proxmox Backup authentication server,这个是给普通pbs用户使用)。 - 去除Proxmox Backup Server未订阅提示(和PVE操作类似,但只需要修改

/usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js文件),注销浏览器当前的PBS登录信息,并重新登录就没有提示弹窗了。

1 | cp /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js.bak |

- 查看并禁用不需要的failed服务(

systemctl命令会输出服务状态情况)

1 | systemctl |

6.7.1 挂载新硬盘到宿主机并设置PVE的PBS备份

- 安装新硬盘用于专门存储PBS的备份数据,这里对应的是

/dev/sdc。 - 在宿主机PVE中,直接格式化整个硬盘为ext4,并挂载到

/mnt/backup-server-data目录。

1 | mkfs.ext4 /dev/sdc |

- 将宿主机PVE的挂载路径映射给PBS的LXC容器。

1 | # 将宿主机的/mnt/backup-server-data映射到LXC容器106的客户机 /mnt/data 路径中 |

- 设置数据目录的属主/属组(Unprivileged非特权容器一定要设置这个操作,否则在下一步的添加数据存储就会报错:

TASK ERROR: EPERM: Operation not permitted)

1 | # 查看proxmox-backup-api的属主/属组 |

- 在PBS后台管理界面中,创建数据存储:数据存储->添加数据存储。

- 常规:名称:HDD,备份路径:/mnt/data,GC时间表:daily,精简时间表:daily。(默认的 daily 表示每天 00:00)

- 精简选项:参见PBS服务器备份精简计划

- 创建命名空间:点击

HDD这个数据存储->内容->新增命名空间->pve-backup- 每个数据存储中可以包含多个命名空间,命名空间并不隔离访问权限与存储设备,仅隔离备份名称。这样子可以实现,多个不同PVE节点可以备份存储在不同的命名空间。

- 创建普通账户给PVE设置备份使用:配置->访问控制->添加->用户名:admin,领域:

Proxmox Backup authentication server,密码:自己设置。- 除仅用于登录管理界面的root用户使用PAM认证外(即

Linux PAM standard authentication),其他管理员用户或备份客户端均使用Proxmox Backup Server自带的用户管理系统进行认证(即Proxmox Backup authentication server)。 - 如果需要设置邮件通知,双击对应帐号,在弹窗里填写

E-Mail一栏即可。

- 除仅用于登录管理界面的root用户使用PAM认证外(即

- 为上一步创建的帐号设置权限:配置->访问控制->权限->用户权限->路径:/datastore/HDD,用户:admin@pbs,角色:DatastoreAdmin。(该角色方便在PVE中管理备份)

- 回到宿主机PVE后台管理界面中,将Proxmox Backup Server添加为存储(Storage):数据中心->存储->添加->Proxmox Backup Server

- 常规:ID:pve-pbs,服务器:10.10.10.8,用户名:admin@pbs,密码:

,Datastore:HDD,命名空间:pve-backup,指纹:[在PBS管理界面首页中查看:仪表板->显示指纹] - 备份保留:默认设置,该功能直接由PBS接管即可,无需在这里设置。

- 加密:如果是首次添加PBS存储,选择自动生成客户端加密密钥。不是首次添加,可以选择上传密钥。注意保存好密钥。

- 常规:ID:pve-pbs,服务器:10.10.10.8,用户名:admin@pbs,密码:

- 在PVE中设置备份任务:数据中心->备份-添加:自行选择需要备份的虚拟机ID。节点:PVE节点,存储:pve-pbs,计划:*/1:00,选择模式:所有,压缩:灰色选项(因为设置了pve-pbs备份存储空间,该选项无法调整),模式:快照。

- 如果是生产数据,比较重要,建议设置备份时间为30分钟一次或者更短时间。

- 如果需要不同的备份时间频率,可以设置多个备份任务。

- 点击备份任务计划,点击

现在运行,查看备份效果。

6.7.2 配置PBS日志轮转清理

这一步很重要,否则长期备份的日志文件会填满的机器根目录。

如果设置备份间隔半小时的话,设置60天轮转一次,PBS占用大约在9.21GB;设置30天轮转一次,大约占用是6.03GB。请根据自己PBS本体安装时的硬盘大小设置合适的轮转周期。

配置方法(保留60天日志文件,一般是凌晨00:00执行轮转任务):

1 | proxmox-backup-manager node update --task-log-max-days 60 |

日志轮转成功执行后,在PBS的网页后台管理菜单->任务:日志轮换,可以查看到相关日志信息

1 | 2025-07-03T00:00:00+08:00: starting task log rotation |

6.7.2.1 Linux日志轮转logrotate服务

logrotate 是基于 crontab 运行的(准确来说是基于timer和crontab定时机制):

- 配置文件

- 主配置文件:

/etc/logrotate.conf,定义全局轮转规则。 - 子配置文件:

/etc/logrotate.d/目录下的文件,定义特定日志的轮转规则。- 创建自定义的轮转任务

mylog:1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20# 创建mylog文件

nano /etc/logrotate.d/mylog

# 填入如下内容

/var/log/mylog.log { # 要轮转的日志文件路径,支持通配符(如 /var/log/mylog/*.log)

daily # 每日轮转

rotate 10 # 保留7个备份,mylog.log.1.gz 到 mylog.log.7.gz

size 10M # 当日志文件超出10M时,轮转

compress # 压缩旧的日志文件

missingok # 若日志文件不存在,不报错

notifempty # 若日志文件为空,不轮转

}

# 修改文件权限,只有拥有者有读写权限;而属组用户和其他用户只有读权限。

chmod 644 /etc/logrotate.d/mylog

# 模拟轮转任务,-d是调试模式

logrotate -d /etc/logrotate.conf

# 模拟mylog的轮转任务

logrotate -d /etc/logrotate.conf/mylog

# 强制执行轮转任务

logrotate -f /etc/logrotate.conf

- 创建自定义的轮转任务

- 主配置文件:

查看相关轮转任务后台服务的命令:

1 | # 查看logrotate版本 |

7 创建PVE虚拟机LXC容器遇到的坑

7.1 使用debian-12的CT模板创建LXC容器SSH终端中文乱码

1 | apt install locales -y |

7.2 非特权(unprivileged)LXC容器无法设置vm.max_map_count内核参数

报错提示:error: permission denied on key 'vm.max_map_count'

报错原因:因为非特权的LXC容器的/proc/sys是以只读方式挂载到容器里面,无法修改sysctl内核参数。

解决方法:在PVE宿主机上设置vm.max_map_count内核参数,max_map_count默认值是262144,而我们需要设置为2000000。

1 | # 持久化设定,永久生效,推荐使用该方式 |

7.2.1 补充知识点:namespace化的sysctl内核参数

vm.max_map_count属于内核参数,而vm.*参数并没有namespace化。只有namespace化的sysctl内核参数在容器内直接修改设置的时候,不会影响宿主机和其他容器。

已经namespace化的sysctl内核参数:

- kernel.shm*

- kernel.msg*

- kernel.sem

- fs.mqueue.*

- net.*

- net.netfilter.nf_conntrack_max(Linux 5.12.2之前并未namespace化)

- net.netfilter.nf_conntrack_expect_max(Linux 5.12.2之前并未namespace化)

给LXC容器单独设置sysctl内核参数的方式:

- 为LXC容器开启特权选项

--privileged,对应/proc目录的挂载方式为rw,可以直接在容器内使用命令修改参数了。若修改的是namespaced参数,则不会影响宿主机和其他容器。 - 把

/proc/sysbind到容器里面,该方式和--privileged效果类似。

给docker容器单独设置sysctl内核参数的方式:

--privileged:docker run --privileged -it ubuntu bash,该方式启动后,可以通过命令任意修改sysctl参数。- 把/proc/sys bind到容器里面,再具体写值,和上面的效果类似。

docker run -v /proc/sys:/writable-sys -it ubuntu bashecho 62 > /writable-sys/net/ipv4/ip_default_ttl

--sysctl:docker run -it --sysctl 'net.ipv4.ip_default_ttl=63' ubuntu sysctl net.ipv4.ip_default_ttl。- 只有namespaced参数才可以。否则会报错"invalid argument..."

- 这种方式只是在容器初始化过程中完成内核参数的修改,容器运行起来以后,/proc/sys仍然是以只读方式挂载的,在容器中不能再次修改sysctl内核参数。

7.3 创建的LXC容器debian-12系统时间与宿主机时间不一致

使用debian-12的CT模板默认使用的是世界时设置,比东八区时间慢八小时,因此需要手动设置时区。

- 方法1:

timedatectl set-timezone Asia/Shanghai - 方法2:

dpkg-reconfigure tzdata

验证修改是否成功:timedatectl

7.4 在PVE管理页面工具选择OpenWrt的自建LXC模板来创建LXC会报错

报错提示:

1 | Logical volume "vm-101-disk-0" created. |

报错原因:PVE管理页面工具无法识别该LXC模板的系统类型。

解决方法:使用pct create手动创建LXC容器。

7.5 非特权模式的OpenWrt的LXC容器网络访问问题

使用unprivileged 1非特权模式创建的LXC容器,OpenWrt的DNSMasq服务无法正常启动,这种模式下网络可以ping通IP,但无法解析域名,提示报错ping: bad address 'qq.com',因为DNSMasq服务异常。

临时解决方法:若需要在这种情况下临时访问外网,直接修改/etc/resolv.conf文件即可,追加可用的DNS服务器IP即可。

1 | vim /etc/resolv.conf |

7.6 LXC容器挂载新路径,共享宿主机目录

1 | pct set 101 -mp0 /mnt/share_folder,mp=/mnt/data |

另一种为非特权LXC容器挂载路径的方式:https://forum.proxmox.com/threads/tutorial-unprivileged-lxcs-mount-cifs-shares.101795/

8 创建PVE虚拟机VM遇到的坑

8.1 添加EFI磁盘后,启动无法引导磁盘,出现shell界面。

原因:创建EFI磁盘时,勾选了添加密钥。

解决方法:创建EFI磁盘时,取消勾选添加密钥。

8.2 安装windows镜像,无法识别找到磁盘

原因:scsi不适合windows镜像,windows安装解决识别不到硬盘。

解决方法:创建硬盘时,总线/设备选择:SATA硬盘或者IDE。

8.3 安装windows镜像,网卡无驱动

现象:当网卡设置为virtio模型时,安装并进入到windows系统后,网卡无驱动。

原因:windows系统自带的驱动无此虚拟硬件的驱动。

解决方式:加载virtio镜像,并运行x64程序安装驱动即可。

VirtIO镜像下载地址:点击跳转

8.4 创建的Windows虚拟机运行一段时间自动挂起进入suspended状态

问题:创建的Windows虚拟机运行一段时间后,会自动挂起进入suspended状态,并且恢复resume系统状态会导致虚拟机内存占用瞬间吃满,然后无响应。

原因:虚拟机Windows系统自身有自动睡眠和关闭屏幕等设置,导致PVE的QEMU自动进入到挂起状态。

解决方法:关闭虚拟机Windows系统内电源设置的自动睡眠和自动关闭屏幕功能。

8.5 虚拟机挂载新路径,共享宿主机目录

https://blog.209902.xyz/archives/1715428748533

9 路由方案一:iKuai主路由+OpenWRT传统旁路由的网络拓扑

iKuai作为主路由,负责拨号及DHCP,OpenWRT做旁路由。SmartDNS+AdGuardHome设置分流与去广告。SmartDNS作为DNS管理并提供DNS缓存,实现国内国外DNS分流,彻底解决DNS污染问题、实现秒开网页。同时搭配AdGuardHome实现整个局域网去广告。

DNS转发流程:设置最核心的部分就是DNS转发端口的衔接,就是把DNSMASQ、Adguardhome、SmartDNS三个插件里的DNS服务器功能分成三个层级,实现层层转发。依次是第一级DNSMASQ,第二级Adguardhome,第三级SmartDNS,第四级OpenClash。

9.1 iKuai的设置

系统设置>重启关机>添加一个重启计划:每天05:00时重启。- 网络设置>内外网设置

- 外网接口(选择iKuai识别到的第二个网口):填入宽带拨号信息。

- 内网接口(iKuai识别到的第一个网口,IP地址192.168.1.1):链路桥接(选择剩余的其他全部接口)

- DHCP设置>DHCP服务端

- 单iKuai版:

- 客户端地址:192.168.1.10-192.168.1.254(1-9留给专用设备的管理地址)

- 子网掩码:255.255.255.0

- 网关:192.168.1.1

- 首选DNS:223.5.5.5

- 备选DNS:114.114.114.114

- iKuai+OpenWrt版本:

- 客户端地址:192.168.1.10-192.168.1.254(1-9留给专用设备的管理地址)

- 子网掩码:255.255.255.0

- 网关:192.168.1.3

- 首选DNS:192.168.1.3

- 备选DNS:192.168.1.3

- 单iKuai版:

- DNS设置>DNS设置

- 单iKuai版:

- 首选DNS:223.5.5.5

- 备选DNS:114.114.114.114

- iKuai+OpenWrt版本:

- 首选DNS:192.168.1.3

- 备选DNS:192.168.1.3

- 单iKuai版:

- UPnP设置>UPnP设置

- UPnP即插即用服务:开启

- 允许内网IP映射:0.0.0.0-255.255.255.255

- 默认线路设置:任意

- 掉线检测:开启

- 检测周期:2

- 定时重启:开启

- 重启周期:全选

- 重启时间:05:00。

9.2 OpenWrt设置

9.2.1 定时重启

系统>定时重启:启用,设置每天05:00。

9.2.2 网络

9.2.2.1 接口>LAN

- IPv4地址:192.168.1.3。管理OpenWrt的地址。

- 和iKuai一致保证同一个网段。

- IPv4网关:指向iKuai的网关。保证OpenWrt的上网数据传输到iKuai再传输到外网。

- 使用自定义的DNS服务器:223.5.5.5(初始先设置阿里云DNS保证设置过程的上网)。后面等设置好SmartDNS之后改由OpenWrt代理,即输入192.168.1.3。

- 关闭DHCP服务,统一由iKuai分配。

- 禁用掉IPv6服务。

- 物理设置:桥接接口。(因为选用的也是)

- lan高级设置:不勾选IPv6,勾选【开启开机自动运行】和【强制链路】。

9.2.2.2 Turbo ACC 加速

只开启前三个即可,DNS缓存后面由SmartDNS来管理。

9.2.2.3 防火墙设置

- SYN-flood 防御:关闭(此项开启关闭都行)

- 丢弃无效数据包:启用(此项开启关闭都行)

- 启用FullCone-NAT:高性能模式

- 入站数据、出站数据、转发都设置为接受。

- lan口开启:IP 动态伪装(只保留lan口的规格,其他接口全部删除)

- 防火墙自定义规则(一般默认就有前四条规则,没有需加上)

1 | iptables -t nat -A PREROUTING -p udp —dport 53 -j REDIRECT —to-ports 53 |

9.2.3 SmartDNS

- 基本设置

- 启用

- 本地端口6053

- 高级设置

- 开启TCP服务器

- 勾选域名预加载

- 勾选缓存过期服务

- 缓存大小设为:1000000

- 域名TTL最大值设为:3600

- 第二DNS服务器

- 启用

- 本地端口5335

- TCP服务器

- 服务器组:oversea

- 跳过测速

- 跳过address规则

- 跳过address SOA(#)规则

- 跳过双栈优选

- 跳过cache

- 停用IPV6地址解析

- 上游服务器(添加DNS的设置里面可以设置服务器组)

- 服务器组名称:china(10条左右,包含iKuai路由宽带拨号返回的两个宽带供应商提供的DNS)

- iKuai路由宽带拨号返回的宽带供应商提供的DNS1,udp协议

- iKuai路由宽带拨号返回的宽带供应商提供的DNS2,udp协议

- 114dns,114.114.114.114,udp协议

- 114dns,114.114.115.115,udp协议

- opener dns,42.120.21.30,udp协议

- 阿里dns,223.5.5.5,udp协议

- 阿里dns,223.6.6.6,udp协议

- 腾讯dns,119.29.29.29,udp协议

- 百度dns,180.76.76.76,udp协议

- 华为dns,122.112.208.1,udp协议

- 服务器组名称:oversea(10条左右)

- google dns,8.8.8.8,udp协议

- google dns,8.8.4.4,tls协议

- CloudFlare,1.1.1.1,udp协议

- IBM Quad9,9.9.9.9,udp协议

- Norton ConnectSafe,199.85.126.10,udp协议

- Norton ConnectSafe,199.85.127.10,udp协议

- OpenDNS,208.67.222.222,tls协议

- OpenDNS,208.67.220.220,udp协议

- V2EX DNS,199.91.73.222,tls协议

- V2EX DNS,178.79.131.110,tls协议

- 服务器组名称:china(10条左右,包含iKuai路由宽带拨号返回的两个宽带供应商提供的DNS)

- 域名规则

- 服务器组:china

- 域名分流设置:跳过测试

- 自定义设置(只设置两条,其他全部注释掉)

1 | bind:6053 -group china |

- 保存&应用

9.2.4 AdGuard Home

9.2.4.1 手动更新内核

- 下载最新的AdGuardHome内核(AdGuardHome_linux_amd64.tar.gz):点击跳转

- 解压获取「AdGuardHome」文件。

- 使用WinSCP登录openwrt虚拟机,进入到路径

/usr/bin/AdGuardHome/,上传「AdGuardHome」文件。右击属性,分配权限0755(rwxr-xr-x)。

9.2.4.2 设置AdGuard Home

- 启用

- AdGuardHome重定向模式:作为dnsmasq的上游服务器

- 详细日志

- 开机后网络准备好时重启

- 在关机时备份工作目录文件(所有的选项)

- 打开192.168.1.3:3000地址并配置

- 网页管理界面>监听接口>所有接口,端口号设置为默认的3000

- DNS 服务器>监听接口>所有接口,端口号设置为5351

- 网页管理界面登录密码

- 设置>常规设置>使用过滤器和Hosts文件以拦截指定域名(其他选项全部关闭)

- 设置>DNS设置

- 上游 DNS 服务器

1

2127.0.0.1:6053

127.0.0.1:5335- 并行请求

- Bootstrap DNS:

127.0.0.1:6053 - 应用

- DNS服务配置

- 速度限制:0

- DNS 缓存配置:都空着(采用上游DNS服务器,让SmartDNS来管理)

- 上游 DNS 服务器

- 设置>过滤器>DNS黑名单设置(将阻止匹配 DNS 拦截清单的域名):综合性的规则列表启用几个即可。

9.2.5 DNSMASQ设置

打开网络>DHCP/DNS。主要是解除DNSMASQ的DNS功能,只保留转发功能,让DNSMASQ作为AdGuard Home的下级服务生效。

- DNS转发:

127.0.0.1#5351。如果未自动设置成这个,手动强制改成这个。 - HOSTS 和解析文件:忽略掉解析文件,不用DNSMASQ的解析。

- 高级设置

- DNS服务器端口:53

- DNS查询缓存的大小:0

- 最大并发查询数:1500

- 保存&应用

9.2.6 OpenClash

9.2.6.1 更新客户端

- 下载客户端安装包:点击跳转

- 使用WinSCP登录openwrt虚拟机,进入到路径家目录home,上传安装包,运行安装

opkg install ./luci-app-openclash_0.46.014-beta_all.ipk。如果报错,尝试opkg update。

9.2.6.2 手动更新内核

内核下载地址:

更新步骤:

- 下载内核。

- 使用WinSCP登录openwrt虚拟机,进入到路径

/etc/openclash/core,上传内核文件。右击属性,分配权限0755(rwxr-xr-x)。

内核对应的名称(压缩包解压出来的名称不一定对应,需手动修改):

- Dev 内核: clash

- Tun 内核: clash_tun

- Meta 内核: clash_meta

9.2.6.3 OpenClash设置

- 运行状态:启动OPENCLASH

- 插件设置

- 模式设置>运行模式:Fake-IP(TUN-混合)模式【UDP-TUN,TCP-转发】

- DNS设置>本地DNS劫持:停用

- GEO数据库订阅:设置自动更新

- 大陆白名单订阅:设置自动更新

- 配置订阅:设置自动更新,更新间隔60分钟

9.2.7 扩容Overlay软件安装空间

- 关闭openwrt虚拟机。

- 硬件>硬盘>更多,调整磁盘大小(只能增加大小,按需增加所需硬盘的空间大小)。

- 打开openwrt虚拟机。

- 系统>磁盘管理L:将新增磁盘大小新建一个分区并格式化为ext4,保存并应用

- 挂载刚才新增的分区,举例sda3:

mount /dev/sda3 /mnt/sda3,保存并应用。 - 拷贝源overlay目录的文件到新分区内:

cp -r /overlay/* /mnt/sda3。 - 系统>挂载点:添加sda3挂载点为「作为外部overlay使用(/overlay)」,保存并应用。

- 重启openwrt虚拟机,检查扩容情况。

- 根据情况可能需手动移除之前挂载的

/mnt/sda3状态。

10 路由方案二:iKuai主路由+OpenWrt旁路由分流的网络拓扑

10.1 iKuai主路由设置

10.2 OpenWrt旁路有设置

TODO

10.3 构建本地机场订阅转换服务

相关核心项目:

- 后端项目:tindy2013/subconverter

- 前端项目:CareyWang/sub-web

- 短链服务:CareyWang/MyUrls

10.3.1 PVE新建一个debian虚拟机

使用LXC模板(debian-12-standard),完成创建之后,并登录该debian虚拟机(可设置SSH连接)

- 容器名称:sub-converter

- 内存:2GB(别分配1.5GB以下的内存,否则不够内存完成构建docker镜像)(构建完成docker镜像后,内存可以调整为512MB)

- Swap:0B

- 核心:4核心(构建完成docker镜像后,核心可以调整为1)

- 根磁盘:5GB(别分配2GB以下的磁盘,否则不够空间完成构建docker镜像)

- 网络:选择已分配给主路由LAN口的网桥(我的情况是:vmbr4,IP静态地址:10.10.10.6/24,网关:10.10.10.1)

10.3.2 设置优化debian虚拟机

- 为debian修改apt镜像源:替换PVE-8-x的Debian系统软件源和PVE软件源(国内镜像)

- 为debian安装docker:使用apt仓库为Debian安装docker

- 为debian系统设置时区:创建的LXC容器debian-12系统时间与宿主机时间不一致

- 为debian系统设置UTF-8语言环境:使用debian-12的CT模板创建LXC容器SSH终端中文乱码

10.3.3 手动重新构建前端docker镜像

- 克隆前端项目

1 | git clone https://github.com/CareyWang/sub-web.git |

- 进入对应仓库路径

cd sub-web - 修改

.env文件内容:nano .env

1 | # 找到以下三行内容,并修改自己的域名或者IP |

- 修改

Subconverter.vue文件内容:nano src/views/Subconverter.vue

1 | # 搜索127.0.0.1内容,并修改为10.10.10.6(该IP是LXC容器debian使用的IP) |

ACL4SSR规则配置:

1 | { |

- 重新构建docker本地镜像

1 | docker build -t subweb-local:latest . |

10.3.4 在root账户用户路径下新建docker-compose.yml:nano docker-compose.yml

1 | services: |

10.3.5 运行docker compose

1 | docker compose -f docker-compose.yml up -d |

10.3.6 验证服务是否运行成功

访问前端页面:http://10.10.10.6

通过tcping验证各个端口是否都正常:

tcping 10.10.10.6 80tcping 10.10.10.6 25500

11 PVE总结

11.1 PVE服务

https://pve.proxmox.com/wiki/Service_daemons

11.2 PVE(Proxmox VE)虚拟机各硬件模型总结

TODO

11.3 PVE服务器的网络拓扑思路

一般而言,TODO

vmbr0为PVE初始创建的默认网桥,一般设置如下参数:

- 固定ip地址

192.168.2.2/24 - 网关

192.168.2.1 - 绑定到一个物理网口

点击创建第二个网桥vmbr1,设置如下参数:

- 固定ip地址

10.10.10.1/24 - 网关留空

- 不绑定物理网卡

编辑PVE宿主机的/etc/network/interfaces文件,添加如下语句实现vmbr1数据转发vmbr0:nano /etc/network/interfaces

1 | auto vmbr1 |

启用并验证

1 | # 启用网桥 |

11.3.1 创建DHCP服务器,为vmbr1网桥的设备自动设置ip地址

1 | apt install isc-dhcp-server -y |

NAT网络转发:转发3389端口

1 | nano /etc/network/interfaces |

iptables命令设置:

1 | #新增 |

11.4 PVE虚拟机磁盘容量调整

- LXC容器的磁盘,在网页控制台设置增加大小,容器会自动增加对应的磁盘分区大小,无需手动在虚拟机系统格式化和挂载。

11.5 PVETOOLS脚本程序推荐

新硬件主机不太推荐安装该脚本,CPU省电相关设置不一定能正常设置成功,恢复时也容易出问题。

- PVETOOLS仓库地址:点击跳转

- 安装步骤(PVE SHELL执行命令):

1 | export LC_ALL=en_US.UTF-8 |

- 执行脚本程序后,可以一键执行「安装配置CPU省电」「配置PVE的web界面显示传感器温度」「去除订阅提示」等功能。

12 PBS(Proxmox Backup Server)总结

12.1 PBS常用命令

1 | # 查看PBS版本 |

12.2 PBS备份计划

重要服务器虚拟机,可以将备份时间设置为半小时或者更短时间。

12.3 PBS服务器备份精简计划

PBS备份精简计划设置效果模拟器:https://pbs.proxmox.com/docs/prune-simulator/index.html

保留设置:

- keep-last(保留上次): 3 - 保留最近 3 次的备份。

- keep-hourly(保留每小时): not set - 若设置了每日备份,这个选项一般无需设置

- keep-daily(保留每天): 13 - 与 keep-last 一起使用,确保至少有两周的每日备份

- keep-weekly(保留每周): 8 - 确保至少有两个月的每周备份

- keep-monthly(保留每月): 11 - 与之前的保留设置一起,这确保至少有一年的每月备份

- keep-yearly(保留每年): 9 - 确保至少 10 年的覆盖

12.4 PBS使用遇到的坑

12.4.1 ERROR: Backup of VM 102 failed - lvcreate snapshot 'pve/snap_vm-102-disk-0_vzdump' error

问题现象:PBS备份服务器或者PVE备份LXC虚拟机容器时出现失败,具体报错信息为

1 | INFO: Starting Backup of VM 102 (lxc) |

问题原因:有残留的同名逻辑卷/dev/pve/snap_vm-102-disk-0_vzdump,一般是上次备份成功之后的清理操作失败导致残留下来的逻辑卷,例如卸载操作失败command 'umount -l -d /mnt/vzsnapo/ failed: got signal 11。

解决方法:

- 查看当前PVE系统中存在的逻辑卷:

lvdisplay,可以查看到/dev/pve/snap_vm-102-disk-0_vzdump逻辑卷属性LV Write Access read only是只读。其他查看命令lvs,lvscan。 - 清理残留的逻辑卷:

- 方法一:

lvremove /dev/pve/snap_vm-102-disk-0_vzdump - 方法二:PVE后台网页控制面板中,对应的虚拟机选项->快照,可以选中对应的vzdump快照删除。

- 方法一:

若遇上报错:lvremove /dev/pve/snap_vm-102-disk-0_vzdump' error: Logical volume pve/snap_vm-102-disk-0_vzdump contains a filesystem in use.,请尝试

- 方案1:重启PVE宿主机

- 方案2:添加

-f参数强制删除,lvremove -f /dev/pve/snap_vm-102-disk-0_vzdump

12.4.1.1 PBS宿主机被日志文件填满根目录

13 iKuai总结

13.1 iKuai爱快内网测试

iKuai爱快内置支持iperf3内网测试工具,但服务端默认并未开启。

开启服务端设置和测试的步骤

- 在iKuai爱快中设置:应用工具->吞吐测试->服务端功能开关(勾选启用)

- 下载iperf3到客户端机器。

- 运行测试命令:

iperf3 -c 192.168.1.1

客户端机器作为服务端的设置步骤:

- 下载iperf3到客户端机器。

- 运行测试命令:

iperf3 -s -p 5201 - 在iKuai爱快的客户端工具连接客户端IP测试。

13.2 iKuai报错提示:写入数据失败,请检查你的配置!

问题:调整iKuai设置,无法保存设置,并报错提示:写入数据失败,请检查你的配置!具体变现为修改配置后,刷新页面后发现设置跟以前一样,并且无法记录流量数据等日志。

原因:磁盘所有分区变成只读模式,没有读写权限,数据无法正常保存。

排查确认方法:iKuai管理后台->应用工具->健康检测。

解决方法:强制断电重启机器。若仍然无法识别到硬盘或者反复出现这种只读权限问题,很可能硬盘出故障,请尽快备份设备文件并更换新硬盘。

13.3 局域网内双iKuai主路由的DHCP的设置

局域网内若有两个iKuai主路由同时提供DCHP服务,并且两个主路由物理上联通的话(两接口分别归属于各自的LAN口),可以在网络设置->DHCP设置->DHCP服务端->关联接口->取消勾选两个路由互联的接口。避免两主路由互相跨网段提供DHCP服务,否则会有潜在的广播风暴问题。(该问题在iKuai路由体检功能也能发现)

13.4 局域网内双iKuai主路由跨网段互相访问(静态路由)

背景假设:一个iKuai地址为192.168.1.1,另一个iKuai地址为192.168.2.1

- 为网段1的iKuai新增扩展IP:网络设置->内外网设置->LAN1->高级设置->扩展IP->新增一个不归属于两个主路由网段的IP,例如

192.168.5.1。- 同理,另外一个iKuai新增IP为

192.168.5.2。

- 同理,另外一个iKuai新增IP为

- 为网段1的iKuai设置静态路由表:网络设置->静态路由->添加->目的地址:

192.168.2.0,子网掩码255.255.255.0 (24),网关:192.168.5.1。- 同理,另外一个iKuai置静态路由表:目的地址:

192.168.1.0,子网掩码255.255.255.0 (24),网关:192.168.5.2。 - iKuai静态路由的网关就是指下一跳。

- 同理,另外一个iKuai置静态路由表:目的地址:

13.5 iKuai设定时间NTP服务器

若在网络拓扑的下游中,存在个别子路由是当作交换机使用,没有接WAN口,无法联网获取时间,导致定时重启等需要时间参数的功能无法使用的话,则可以将iKuai设定为NTP服务器。

iKuai后台设置问题:系统设置->基础设置->时间设置->NTP服务->勾选开启(网关作为NTP服务器)。

14 OpenWrt总结

14.1 OpenClash报错all DNS requests failed或者dns resolve failed

问题:通过机场订阅配置后,发现部份被分流到海外的IP和域名无法正常访问。查看OpenClash后台的内核日志,是因为有大量的all DNS requests failed或者dns resolve failed错误提示。并且该现象只会出现在个别机场订阅上,有些机场订阅是正常工作。

原因:部份机场比较挑剔OpenClash的DNS设置。

解决方法:OpenClash->覆写设置->DNS设置

FallBack和Default-NameServer的DNS设置比较重要,对于笔者而言,8.8.4.4, UDP是能有效解决上述问题。

- 【勾选】自定义上游DNS服务器

- 【勾选】追加上游DNS

- 【勾选】追加默认DNS

- 【勾选】Fallback-Filter

- 设置自定义上游 DNS 服务器(在上方设置中启用本功能后生效)

- NameServer

- 223.5.5.5/dns-query, HTTPS

- 223.6.6.6/dns-query, HTTPS

- 8.8.8.8, UDP

- FallBack

- 8.8.4.4, UDP

- Default-NameServer

- 114.114.114.114, UDP

- 223.5.5.5, UDP

- 8.8.8.8, UDP

- 8.8.4.4, UDP

- NameServer

15 飞牛私有云fnOS(NAS总结)

15.1 EMBY+MetaTube Server实现影视刮削

- 在飞牛的应用中心中安装

EMBY并通过wizardstart配置好帐号。 - 打开

docker应用,点击compose页面,在飞牛的存储中,创建metatube文件夹路径存放docker-compose.yaml的文件(以下卷映射也是基于该路径的相对路径),输入如下内容保存运行:metatube的docker-compose.yaml1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33services:

metatube:

image: ghcr.io/metatube-community/metatube-server:latest

container_name: metatube

ports:

- "8080:8080"

restart: unless-stopped

depends_on:

- postgres

environment:

- HTTP_PROXY=

- HTTPS_PROXY=

- TZ=Asia/Shanghai

volumes:

- run:/var/run

command: -dsn "postgres://metatube:metatube@/metatube?host=/var/run/postgresql" -port 8080 -db-auto-migrate -db-prepared-stmt

postgres:

image: postgres:15-alpine

container_name: metatube-postgres

restart: unless-stopped

environment:

- POSTGRES_USER=metatube

- POSTGRES_PASSWORD=metatube

- POSTGRES_DB=metatube

- TZ=Asia/Shanghai

volumes:

- ./db:/var/lib/postgresql/data

- run:/var/run

command: "-c TimeZone=Asia/Shanghai -c log_timezone=Asia/Shanghai -c listen_addresses='' -c unix_socket_permissions=0777"

volumes:

run: - 下载Metatube的插件,放置于

/vol1/@appdata/EmbyServer4-9/plugins(应用->文件管理->管理员视角),重启EMBY应用。 - 在

EMBY的控制台,高级->插件,找到Metatube,点击设置,填入第二步的部署docker的ip+端口:就是http://飞牛IP:8080,点击底部的保存。 - 然后在

EMBY的控制台,Emby Server->媒体库,这里可以新增和调整元数据的设置参数。

15.2 Komga服务端图书馆

- 打开

docker应用,点击compose页面,在飞牛的存储中,创建komga文件夹路径存放docker-compose.yaml的文件(以下卷映射也是基于该路径的相对路径),输入如下内容保存运行:komga的docker-compose.yaml1

2

3

4

5

6

7

8

9

10

11

12

13

14

15services:

komga:

image: gotson/komga

container_name: komga

volumes:

- ./config:/config

- ./data:/data

- /etc/timezone:/etc/timezone:ro

ports:

- 25600:25600

user: "1000:1000"

# remove the whole environment section if you don't need it

# environment:

# - <ENV_VAR>=<extra configuration>

restart: unless-stopped - 访问地址:

http://飞牛IP:25600,配置帐号/密码(帐号要求为邮箱地址)。

15.3 Talebook服务端图书馆

- 打开

docker应用,点击compose页面,在飞牛的存储中,创建talebook文件夹路径存放docker-compose.yaml的文件(以下卷映射也是基于该路径的相对路径),输入如下内容保存运行:talebook的docker-compose.yaml1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22services:

# main service

talebook:

restart: always

image: talebook/talebook

volumes:

- ./data:/data

ports:

- "8090:80"

#- "8443:443"

environment:

- PUID=1000

- PGID=1000

- TZ=Asia/Shanghai

depends_on:

- douban-rs-api

# optional, for meta plugins

# please set "http://douban-rs-api" in settings

douban-rs-api:

restart: always

image: ghcr.io/cxfksword/douban-api-rs - 访问地址:

http://飞牛IP:8090,配置帐号/密码/邮件。 - 手机APP

静读天下-moonreader右上角,增加新书库,书库地址:http://飞牛IP:8090/opds/。

15.4 下载应用例如QBittorrent在后台上传时可能会引导硬盘持续读取和CPU的异常占用。

问题原因:系统Swap cache功能引起引起硬盘持续读取和CPU的异常占用。

解决方法:永久禁用Swap cache功能。

- 访问PVE的fnOS虚拟机控制台或者开启SSH远程访问权限。

- 登录fnOS账户。

sudo vim /etc/fstab- 摁

I键进入vim编辑器编辑模式 - 找到

/swapfile none swap sw 0 0一行内容并注释掉,即在行头加上#。 - 摁

ESC键,摁:键然后输入wq!保存退出。 cat /etc/fstab可以查看文件内容是否修改成功,输出内容如下:

1 | UUID=ea545bcc-cd3f-479f-902a-ab2b02db25 / ext4 errors=remount-ro 0 1 |

15.5 应用中心安装AutoBangumi跳过首次配置页面之后,无法再次访问

问题现象:在应用中心安装AutoBangumi之后,首次访问http://ip:17892/端口的配置页面时,若不配置qbit的下载端口时。关闭页面,尝试二次访问该端口时,页面被拒绝访问,连接失败。通过Docker应用查看容器的运行日志:

1 | [2025-09-02 00:30:13] ERROR [Checker] Downloader connect failed. |

问题原因:没有配置qbit的下载端口,AutoBangumi未能检测到下载器。

解决方法:

- 方法一:停用

AutoBangumi后再启用。 - 方法二:卸载删除数据并重装应用

- 卸载

AutoBangumi应用。 - 打开

文件管理,定位到应用文件路径,删除AutoBangumi文件夹 - 重新安装

AutoBangumi应用 - 访问

http://ip:17892/端口即可访问成功

- 卸载

16 宽带网络总结

16.1 会话数(连接数)

会话数(连接数)在线测试工具:https://qps.itzmx.com

连接数为应用产生的网络连接数,例如在爱快首页上看到连接数。并发连接数为 qps ,即每秒发起请求,等于在同一秒内,产生了 250 个请求。

会话数(连接数)的限制,一般普通线路带宽会有会话数限制,专线则没有该限制。触发限制的常见现象为:超过并发连接数上限后,此前已建立连接数的软件和网络请求可正常通信,并且期间ping一切正常,延迟没有任何抖动现象,但是新开软件则连不上网络。

17 机场相关

17.1 自动签到领取机场流量

- Fork仓库

https://github.com/bighammer-link/jichang_checkin到自己的GitHub帐号 Settings->Secrets and variables→Actions:New repository secret- NAME:

URL,值填写机场域名网址,例如https://example.com,尾部不要加/。 - NAME:

CONFIG,值填写机场的帐号(一般是邮箱)和密码。一行账号一行密码。- 第一行:帐号,即邮箱

- 第二行:密码

- NAME:

- 在

Actions中创建一个workflow,手动运行一次,后续会每日自动运行。

18 后记

这光猫还是有断流情况,估计是过热导致掉线,后续考虑下加装小风扇。

断流降速故障已查明:虚拟网卡模型设置为Intel E1000导致的故障,重设为VirtIO (半虚拟化)即可解决。

19 All in One (All in Boom) 机器硬件选型总结

19.1 CPU选型对比

| CPU型号 | 内核/线程 | 功耗/W | 频率/GHz | 核显最大分辨率 | 最大内存规格/GB | VT-x | VT-d |

|---|---|---|---|---|---|---|---|

| 赛扬®J1900 | 4/4 | 10 | 2~2.42 | 未知 | 2×8 DDR3L 1333MT/s | 支持 | 不支持 |

| 奔腾®N3530 | 4/4 | 4.5~7.5 | 2.16~2.58 | 未知 | 2×8 DDR3L 1333MT/s | 支持 | 不支持 |

| 奔腾®J4205 | 4/4 | 10 | 1.5~2.6 | 未知 | 2×8 LPDDR4 2400 MT/s DDR3L/LPDDR3 1866 MT/s; | 支持 | 支持 |

| 赛扬®J4125 | 4/4 | 10 | 2~2.7 | DP:4096x2160@60Hz HDMI:4096x2160@30Hz eDP:4096x2160@60Hz | 2×8 DDR4/LPDDR4 2400MT/s | 支持 | 支持 |

| 赛扬®J6412 | 4/4 | 10 | 2~2.6 | DP:4096 x 2160@60Hz eDP:4096 x 2160@60Hz | 4x32 LPDDR4/x 3733MT/s 2x64 DDR4 3200MT/s | 支持 | 支持 |

| N100 | 4/4 | 6 | 3.4 | DP:4096 x 2160@60Hz HDMI:4096 x 2160@60Hz | 16 DDR5 4800 MT/s 16 DDR4 3200 MT/s 16 LPDDR5 4800 MT/s | 支持 | 支持 |

| 酷睿™ i7-1255U | 10/12 | 12~55 | E核3.5 P核4.7 | DP:7680 x 4320 @ 60Hz HDMI:4096 x 2304 @ 60Hz eDP:4096 x 2304 @ 120Hz | 64 LDDR5 4800 MT/s 64 DDR4 3200 MT/s 64 LPDDR5 5200 MT/s 64 LPDDR4x 4267 MT/s | 支持 | 支持 |

| 酷睿™ i3-12100 | 4/8 | 60~89 | 无E核 P核3.3~4.3 | DP:7680 x 4320 @ 60Hz HDMI:4096 x 2160 @ 60Hz eDP:5120 x 3200 @ 120Hz | 128 DDR5 4800 MT/s 128 DDR4 3200 MT/s | 支持 | 支持 |

| 酷睿™ i3-12300 | 4/8 | 60~89 | 无E核 P核3.5~4.4 | DP:7680 x 4320 @ 60Hz HDMI:4096 x 2160 @ 60Hz eDP:5120 x 3200 @ 120Hz | 128 DDR5 4800 MT/s 128 DDR4 3200 MT/s | 支持 | 支持 |

| 酷睿™ i5-12400 | 6/12 | 65~117 | 无E核 P核2.5~4.4 | DP:7680 x 4320 @ 60Hz HDMI:4096 x 2160 @ 60Hz eDP:5120 x 3200 @ 120Hz | 128 DDR5 4800 MT/s 128 DDR4 3200 MT/s | 支持 | 支持 |

| 酷睿™ i3-13100 | 4/8 | 60~110 | 无E核 P核3.4~4.5 | DP:7680 x 4320 @ 60Hz HDMI:4096 x 2160 @ 60Hz eDP:5120 x 3200 @ 120Hz | 192 DDR5 4800 MT/s 192 DDR4 3200 MT/s | 支持 | 支持 |

| 酷睿™ i3-14100 | 4/8 | 60~110 | 无E核 P核3.5~4.7 | DP:7680 x 4320 @ 60Hz HDMI:4096 x 2160 @ 60Hz eDP:5120 x 3200 @ 120Hz | 192 DDR5 4800 MT/s 192 DDR4 3200 MT/s | 支持 | 支持 |

| 酷睿™ i7-12700K | 12/20 | 125-190 | E核2.7~3.8 P核3.6~4.9 | DP:7680 x 4320 @ 60Hz HDMI:4096 x 2160 @ 60Hz eDP:5120 x 3200 @ 120Hz | 128 DDR5 4800 MT/s 128 DDR4 3200 MT/s | 支持 | 支持 |

| 酷睿™ i7-1265U | 10/12 | 12~55 | E核3.6 P核4.8 | DP:7680 x 4320 @ 60Hz HDMI:4096 x 2304 @ 60Hz eDP:4096 x 2304 @ 120Hz | 64 DDR5 4800 MT/s 64 DDR4 3200 MT/s 64 LPDDR5 5200 MT/s 64 LPDDR4x 4267 MT/s | 支持 | 支持 |

19.2 主板选型对比

| 主板型号 | 内存插槽 | 供电 | 网口情况 | SATA支持 | M.2支持 | PCIe通道 | 显示接口 | PCB设计板层 |

|---|---|---|---|---|---|---|---|---|

| 云星Matx-Z690 NAS主板 | 4 x DDR4内存槽 最大支持4 x 32G=128G | 8+1+1相 | 4 x Intel I226-V 2.5G | 8 x SATA 3.0 | 2 x PCIe4.0 x4正面 2 x PCIe3.0 x4反面 | 2 x PCIe4.0 x16插槽(x8带宽) PCIe4.0 x4插槽(x4带宽) | HDMI2.0 DP1.4 | 6层 |

20 参考文献

[1] Installation Failing: "Failed to prepare EFI boot using Grub"[EB/OL]. https://forum.proxmox.com/threads/installation-failing-failed-to-prepare-efi-boot-using-grub.122002/.

[2] 软路由科普系列 篇二:PVE安装iKuai OpenWrt 旁路由 基础设置 保姆级全教程[EB/OL]. https://post.smzdm.com/p/awrx4lxm/.

[3] ProxmoxVE 7.4 升级到 8.0,详细步骤[EB/OL]. https://blog.margrop.net/post/pve-7-upgrade-to-8/.

[4] PVE 联网及更换国内源[EB/OL]. https://www.cnblogs.com/pdblogs/p/16218543.html.

[5] Force update from unsigned repository[EB/OL]. https://askubuntu.com/questions/732985/force-update-from-unsigned-repository.

[6] ProxmoxVE(PVE) 启用 IOMMU[EB/OL]. https://www.insilen.com/post/501.html.

[7] Enable IOMMU or VT-d in your motherboard BIOS[EB/OL]. https://us.informatiweb.net/tutorials/it/bios/enable-iommu-or-vt-d-in-your-bios.html.

[8] ProxmoxVE(PVE) 使用 IMG 镜像文件,img 转 qcow2[EB/OL]. https://www.lxtx.tech/index.php/archives/65/.

[9]『软路由踩坑指南』篇三:ESXi 8.0 虚拟机安装 iKuai 主路由及保姆级配置[EB/OL]. https://post.smzdm.com/p/a5op28x7/.

[10]『软路由踩坑指南』篇四:ESXi 8.0 虚拟机安装 openWrt 路由系统终极指南[EB/OL]. https://post.smzdm.com/p/a7ngxeel/.

[11]『软路由踩坑指南』篇五:OpenWrt 旁路由进阶篇 SmartDNS+AdGuardHome 设置 DNS 分流、秒开网页、去广告[EB/OL]. https://post.smzdm.com/p/axz6z7w9/.

[12] [openwrt(x86)] OPenWRT 旁路由 +MosDNS+OpenClash+AdGuard Home 傻瓜配置图文教程[EB/OL]. https://www.right.com.cn/forum/thread-8284982-1-1.html.

[13] OpenWrt 扩容 Overlay 和 Docker 软件安装空间教程(内置硬盘版)附:Samba 网络共享设置[EB/OL]. https://www.right.com.cn/forum/thread-7470757-1-1.html.

[14] [OpenWrt] 使用 OpenClash 科学上网[EB/OL]. http://suyu0925.github.io/blog/2022/07/25/openwrt-openclash/.

[15] 镜像站使用帮助-Proxmox 软件仓库[EB/OL]. https://mirrors.tuna.tsinghua.edu.cn/help/proxmox/.

[16] 开启直通[EB/OL]. https://skyao.io/learning-pve/docs/pass-through/enable/.

[17] [经验分享] 在线连接数测试网页,简单一键测试宽带并发连接数限制[EB/OL]. https://bbs.ikuai8.com/thread-87196-1-1.html.

[18] 禁用Swap cache[EB/OL]. https://club.fnnas.com/forum.php?mod=viewthread&tid=2492.

[19] 镜像站使用帮助-Debian 软件源[EB/OL]. https://mirrors.tuna.tsinghua.edu.cn/help/debian/.

[20] 第 5 章 bookworm 中需要注意的问题[EB/OL]. https://www.debian.org/releases/bookworm//amd64/release-notes/ch-information.zh-cn.html.

[21] 【装机帮扶站】第881期:BUG处理器能选否?聊聊12代ES处理器[EB/OL]. https://zhuanlan.zhihu.com/p/458166029.

[22] 爱快ikuai和windows电脑使用iperf3测试内网传输速度[EB/OL]. https://www.mulingyuer.com/archives/1073/.

[23] PVE8.3.0折腾记(一)——PVE初次安装后更换国内源[EB/OL]. https://blog.csdn.net/weixin_52626278/article/details/144147244.

[24] 解决PVE安装独显后,核显消失,无法直通的问题。[EB/OL]. http://157.0.230.2:8090/archives/owKXsHkN.

[25] PVE下LXC ubuntu 中文乱码解决[EB/OL]. https://blog.csdn.net/zyr920425/article/details/131126045.

[26] Proxmox VE常见问题以及解决办法(持续更新)[EB/OL]. https://blog.csdn.net/qq_40858216/article/details/106784329.

[27] Proxmox VE面板节点和虚拟机提示问号,节点状态 unknown,储存一直打不开,虚拟机正常的诊断思路[EB/OL]. https://www.wjxy.net.cn/?p=2629.

[28] 给容器设置内核参数[EB/OL]. https://cloud.tencent.com/developer/article/1583736.

[29] Using sysctls in a Kubernetes Cluster[EB/OL]. https://kubernetes.io/docs/tasks/administer-cluster/sysctl-cluster/#listing-all-sysctl-parameters.

[30] setting key "vm.max_map_count": Read-only file system[EB/OL]. https://forum.proxmox.com/threads/setting-key-vm-max_map_count-read-only-file-system.28720/.

[31] After installation with Ventoy rdinit=/vtoy/vtoy[EB/OL]. https://forum.proxmox.com/threads/after-installation-with-ventoy-rdinit-vtoy-vtoy.153979/.

[32] 升级至QEMU 9.2.0后直通失败[EB/OL]. https://github.com/gangqizai/igd/issues/27.

[33] 每过段时间修改编辑配置那些失效[EB/OL]. https://bbs.ikuai8.com/forum.php?mod=viewthread&tid=146800&extra=page%3D1%26filter%3Dtypeid%26typeid%3D20.

[34] proxmox安装定义磁盘分区大小[EB/OL]. https://www.cnblogs.com/weihua2020/p/13723466.html.

[35] minfree for lvm snapshots[EB/OL]. https://forum.proxmox.com/threads/minfree-for-lvm-snapshots.28977/.

[36] Backup fails with Logical Volume already exists in volume group[EB/OL]. https://forum.proxmox.com/threads/backup-fails-with-logical-volume-already-exists-in-volume-group.42377/.

[37] PVE8.3.1 LXC下安装 OpenWRT 记录[EB/OL]. https://www.cnblogs.com/airoot/p/18715211.

[38] LXC容器中安装openwrt作为主路由[EB/OL]. https://blog.jmal.top/s/lxc-openwrt-main-router.

[39] ping: bad address ‘openwrt.org’[EB/OL]. https://blog.axiaoke.cn/archives/1173.html.

[40] Proxmox VE 容器或虚拟机被锁定解决办法[EB/OL]. https://www.wort.cloud/post/notes/proxmox-ve-lxc%e5%ae%b9%e5%99%a8%e8%a2%ab%e9%94%81%e5%ae%9a%ef%bc%8c%e7%8a%b6%e6%80%81%e4%b8%barollback%e8%a7%a3%e5%86%b3%e5%8a%9e%e6%b3%95/.

[41] kyleflower/clash_rules[EB/OL]. https://github.com/kyleflower/clash_rules.

[42] docker搭建MyUrls短链服务,可配合sub-web食用[EB/OL]. http://213.35.110.223:8000/2024/08/1724228021116.

[43] 自建Clash订阅转换 - Subconverter+Subweb+MyUrls搭建教程 (Docker版本)[EB/OL]. https://crossbell.io/notes/59373-1.

[44] 自建Clash订阅转换 - Subconverter+Subweb+MyUrls搭建教程 - 全docker完成 - mihomo内核 避坑指南[EB/OL]. https://imgki.com/archives/718.html.

[45] 自建Clash订阅转换[EB/OL]. https://lwnlh.com/14_Self-built_Clash_Subscription_Conversion.html.

[46] .env 配置在 Docker 中不起作用[EB/OL]. https://github.com/CareyWang/sub-web/issues/68.

[47] [BUG] 使用 Clash Meta 内核开启tun模式出现 connect error: dns resolve failed: context deadline exceeded[EB/OL]. https://github.com/clash-verge-rev/clash-verge-rev/issues/104.

[48] openclash "all DNS requests failed, first error: dns: bad rdata"错误解决[EB/OL]. https://zhuanlan.zhihu.com/p/670131605.

[49] 我的家里pve虚拟机经常死机原来是原因这导致的[EB/OL]. https://blog.csdn.net/u010042660/article/details/139935170.

[50] pve节点频繁宕机问题排查[EB/OL]. https://www.cnblogs.com/nf01/p/16296724.html.

[51] pve8.0 cpu是1265u经常死机,进不去,需要断电重启[EB/OL]. https://tieba.baidu.com/p/8488486698.

[52] PBS 维护任务[EB/OL]. https://www.cnblogs.com/varden/p/15251582.html.

[53] 使用 Proxmox Backup Server 备份 Proxmox VE 的客户机与宿主机[EB/OL]. https://blog.men.ci/backup-pve-with-pbs/.

[54] Installation[EB/OL]. https://pbs.proxmox.com/docs/installation.html.

[55] CUSTOM SCHEMES USING .LINK FILES[EB/OL]. https://wiki.debian.org/NetworkInterfaceNames#CUSTOM_SCHEMES_USING_.LINK_FILES.

[56] ProxmoxVE操作指南(已更新至pve8.0)[EB/OL]. https://ifwww.com/posts/61099.html.

[57] Is there any purge facility to free up disk space?[EB/OL]. https://forum.proxmox.com/threads/is-there-any-purge-facility-to-free-up-disk-space.110575/.

[58] Proxmox-backup logs[EB/OL]. https://forum.proxmox.com/threads/proxmox-backup-logs.98220/.

[59] How does task-log-max-days work?[EB/OL]. https://forum.proxmox.com/threads/how-does-task-log-max-days-work.160627/.

[60] Linux日志切割神器logrotate原理介绍和配置详解[EB/OL]. https://blog.csdn.net/wangliang888888/article/details/134575630.

[61] Linux自带神器logrotate详解[EB/OL]. https://www.cnblogs.com/txlsz/p/13126723.html.

[62] 使用logrotate实现日志轮转[EB/OL]. https://blog.csdn.net/LONG_Yi_1994/article/details/147464654.

[63] 年轻人折腾的第一台独服 – PVE 7.4 + NAT 内网 + DHCP + K8S 多节点集群 + Istio + CertManager(letsencrypt)[EB/OL]. https://doraemonext.com/archives/347.html.

[64] AutoBangumi安装问题[EB/OL]. https://club.fnnas.com/forum.php?mod=viewthread&tid=18727.

[65] MetaTube Sever deployment (后端部署)[EB/OL]. https://metatube-community.github.io/wiki/server-deployment/#docker-compose.

[66] 【Docker】搭建一个媒体服务器插件后端API服务 - MetaTube[EB/OL]. https://blog.mvui.cn/detail/7100.html.

[67] 飞牛NAS搭建私人图书馆,实现网页、手机看电子书[EB/OL]. https://club.fnnas.com/forum.php?mod=viewthread&tid=16419.

[68] proxmox container uid/gid mapping[EB/OL]. https://forum.proxmox.com/threads/proxmox-container-uid-gid-mapping.129544/.

[69] PVE使用lxc.mount.entry,让LXC容器共享宿主机目录[EB/OL]. https://blog.209902.xyz/archives/1715429836621.